Dahaga AI akan Daya Listrik yang Tidak Pernah Terpenuhi

Kecerdasan buatan (Artificial Intelligence/AI) sudah menjadi elemen integral dalam kehidupan sehari-hari. Dari asisten virtual seperti ChatGPT hingga sistem rekomendasi perjalanan, belanja online, dan analisis kesehatan digital, AI merevolusi cara kita berinteraksi dengan teknologi.

Namun di balik kenyamanannya, muncul pertanyaan krusial yang sering luput dibahas: berapa besar kebutuhan energi listrik untuk menjalankan AI, dan bagaimana dampaknya bagi masa depan lingkungan serta infrastruktur energi global?

Berapa Konsumsi Daya untuk AI?

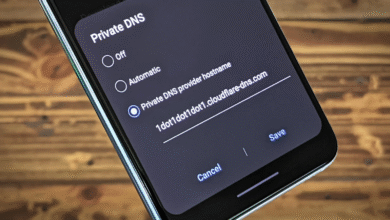

Untuk menjawab pertanyaan ini, penulis mencoba bertanya langsung kepada Grok—chatbot berbasis AI milik Elon Musk. Saat ditanya berapa banyak listrik yang digunakan AI setiap kali menjawab pertanyaan, Grok menjawab:

“Susah banget buat ngasih angka pasti karena pemakaian daya tergantung sama berbagai hal kayak alat apa yang lagi dipakai, seberapa irit server ngerjain pertanyaannya, sampe tingkatin kesulitan dari permintaan tersebut… Mungkin antara 0,01 sampai 0,1 Wh buat soal yang gampang-gampangan.”

Sekilas angka tersebut terlihat kecil. Namun, jika dikalikan dengan miliaran hingga triliunan permintaan tiap hari, dampaknya menjadi signifikan.

Prediksi Konsumsi Energi AI Global

Menurut laporan dari International Energy Agency (IEA), penggunaan energi oleh pusat data global—termasuk yang mengoperasikan AI—diperkirakan meningkat lebih dari dua kali lipat pada 2030, mencapai 945 TWh. Angka ini melampaui konsumsi listrik seluruh Jepang saat ini.

Sementara itu, McKinsey & Company memperkirakan kebutuhan energi pusat data di Amerika Serikat akan melonjak dari 147 TWh (2023) menjadi 606 TWh pada 2030. Ini mencakup sekitar 11,7% dari total konsumsi energi AS, menjadikan AI sebagai pengguna utama listrik global di masa depan.

Konsumsi Energi dalam Pelatihan dan Inferensi AI

Proses pelatihan model AI berskala besar menyedot energi dalam jumlah besar. Sebagai contoh, pelatihan GPT-3 memerlukan sekitar 1.300 MWh, setara konsumsi listrik 120 rumah di AS dalam setahun.

Saat digunakan (tahap inferensi), AI tetap membutuhkan daya. Estimasi menyebutkan bahwa satu interaksi dengan ChatGPT bisa mengonsumsi sekitar 3 Wh—mirip dengan menyalakan lampu 3 watt selama satu jam. Jika ada 10 juta pengguna aktif yang mengajukan 10 pertanyaan per hari, total konsumsinya bisa mencapai 300 GWh per hari, cukup untuk memenuhi kebutuhan listrik 30.000 rumah.

Namun, perhitungan ini bisa berbeda. Menurut Epoch AI, konsumsi energi per permintaan ChatGPT hanya sekitar 0,3 Wh, jauh lebih kecil namun tetap di atas pencarian Google yang hanya menggunakan 0,0003 Wh. Perbedaan ini bergantung pada jenis model, kesulitan permintaan, serta efisiensi server.

Dampak Lingkungan: Dari Emisi hingga Konsumsi Air

Penggunaan energi dalam jumlah besar tentu menimbulkan jejak karbon. Kecuali energi yang digunakan berasal dari sumber terbarukan, AI berpotensi memperburuk krisis iklim.

Laporan dari The New York Times (2022) menyatakan bahwa pusat data—fondasi teknologi AI—mengonsumsi 1–1,3% dari total pasokan listrik global. Pada 2024, angkanya meningkat menjadi 415 TWh atau sekitar 1,5% dari total konsumsi energi dunia.

Di AS, Laboratorium Berkeley mencatat pusat data mengonsumsi 176 TWh listrik pada 2023 (sekitar 4,4% total energi nasional), dan diperkirakan akan naik tiga kali lipat hingga 2028. Jepang bahkan mencatat bahwa lebih dari separuh peningkatan energi disebabkan oleh pusat data AI.

Menurut MIT Technology Review, pelatihan satu model AI bisa menghasilkan 626.000 pon CO₂, setara lima kali emisi satu mobil sepanjang masa pakainya. Sementara itu, kebutuhan pendinginan pusat data memicu konsumsi air skala besar—hingga dua liter air per kilowatt-jam, menurut studi dari University of California. Diproyeksikan, permintaan air global untuk AI bisa mencapai 6,6 miliar meter kubik pada 2027, setara konsumsi air tahunan negara Denmark.

Sampah Elektronik dan Umur Pakai Perangkat

Selain energi dan air, AI juga berkontribusi pada peningkatan sampah elektronik. Umur pakai pendek dari GPU dan perangkat High Performance Computing (HPC) menciptakan tantangan baru dalam pengelolaan limbah elektronik.

Menuju AI yang Ramah Energi

Ketergantungan AI pada listrik menimbulkan kekhawatiran akan ketahanan energi. Untuk itu, beberapa ahli menyerukan peran pemerintah, perusahaan teknologi, dan pembuat kebijakan dalam mengarahkan AI ke jalur yang lebih berkelanjutan.

Charlotte Wang, pendiri EQuota Energy, menyuarakan pentingnya regulasi dan transparansi dalam penggunaan energi oleh AI:

“Bagaimana kita bisa menghindari ketidakadilan dalam menciptakan solusi energi berbasis AI? Siapa yang punya wewenang untuk membuat keputusan? Transparansi adalah kunci.”

— Yale Clean Energy Forum, Februari 2025.

IEA juga menyerukan peningkatan efisiensi pusat data dan percepatan adopsi energi bersih. Beberapa pendekatan yang kini diterapkan termasuk:

Model AI kecil dan spesifik untuk mengurangi beban komputasi.

Penggunaan chip hemat energi seperti GPU khusus dan komputasi kuantum.

Optimisasi algoritme agar lebih hemat energi.

Beralih ke energi terbarukan seperti matahari dan angin.

Contohnya, Google melalui DeepMind, berhasil mengurangi konsumsi energi pusat datanya hingga 40%.

Peran Konsumen dalam Pengurangan Dampak

Sebagai pengguna AI, kita juga memiliki peran dalam menekan jejak lingkungan. Dengan membatasi penggunaan yang tidak perlu, serta memilih penyedia layanan AI yang mengutamakan sumber energi berkelanjutan, kita turut berkontribusi pada masa depan teknologi yang ramah lingkungan.